Нам задают вопросы: «какие программы для аудита

использовать», «как автоматически собрать ключевые запросы»,

«каким сервисом посмотреть теги на своем сайте» и т.д. Именно

просьбы наших читателей подтолкнули к написанию статьи с обзором

полезных продуктов, которые можно использовать для решения

разных задач: проведения анализа сайта, сбора семантического

ядра и не только. Берите эти инструменты на вооружение

и упрощайте работу над своими проектами, экономя время и бюджет.

Итак, начнем обзор.

ComparseR

ComparseR – программа, разработанная Александром Алаевым, директором

веб-студии «АлаичЪ и Ко». Специализированный инструмент для парсинга, который

позволяет глубоко изучить индексацию сайта. Компарсер помогает просканировать

и изучить важные теги, найти технические ошибки (дублированный контент, битые

ссылки, внутренние редиректы и не только). Главное отличие программы

от аналогов – сканирование страниц сайта из поисковой выдачи и сравнение

их с полученными данными самого сайта.

ComparseR платный, купить лицензию можно за 2000 рублей. Но доступна

демоверсия, возможности, конечно, ее ограничены, но прежде чем приобретать

инструмент для парсинга за деньги, советую начать с бесплатной версии.

Давайте рассмотрим, что же может ComparseR. От себя добавлю: если вы хотите

собрать основные данные о своем сайте, просканировать страницы, увидеть сайт

глазами поисковых систем, комплексно изучить все недочеты в тегах, найти

технические ошибки, то, пожалуй, этот инструмент один из самых лучших.

При запуске программы в настройках вы сможете выставить параметры проверки:

ComparseR собирает данные о тегах Title и Description:

Вы можете проанализировать заголовки каждой страницы, разделы отдельно

разбиты на заголовки Н1-Н2 и Н3-Н6:

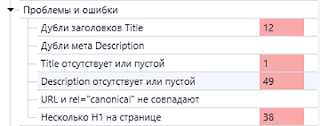

Открыв вкладку «Статистика и структура», вы можете детально проанализировать

основные параметры и в числах увидеть статистику по важным факторам:

Пункт «Ответ сервера» укажет вам, какие внутренние редиректы есть на сайте,

имеются ли 404 страницы, количество страниц с ответом сервера 200 и другими:

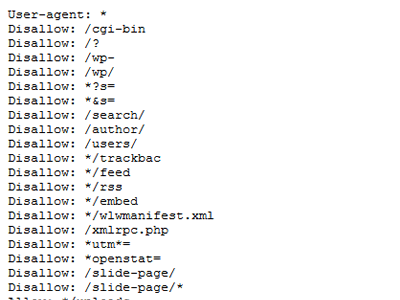

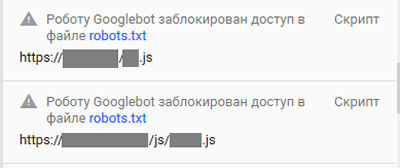

Здесь же можно посмотреть запрещенные и открытые к индексации в мета-теге

robots и файле robots.txt страницы и документы:

В разделе «Статистика» есть возможность увидеть количество отсутствующих или

повторяющихся тегов Title и Description, узнать проблемы с заголовками H1:

Кликнув на каждую строчку, вы получите полную информацию о страницах,

на которых найдены проблемы:

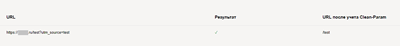

Также вы сможете посмотреть, как видят ваш сайт поисковики Яндекс и Google.

Именно эту функцию разработчик выделяет как свое основное отличие и преимущество

перед аналогами:

Но и это не все, в Компарсере, в разделе «Внешние ссылки», вы найдете полную

информацию о ссылках, ведущих на сайт: анкорные они или без, с каких источников

ведут, не являются ли они битыми, открыты или закрыты от индексации.

Кроме того, можно проанализировать изображения на сайте: какой ответ сервера

у страниц сайта, открыты ли для индексации, какой вес имеют, а главное

прописаны ли атрибуты Alt и Title для изображения. Ведь каждый оптимизатор

знает, что у всех картинок на сайте должны быть соответствующие описания,

в состав которых входят важные ключевые запросы. Вы же об этом знали?

Часть функций Компарсера я вам показала, платная версия откроет

дополнительные возможности для проверки. Хочу еще отметить, что многие программы

для парсинга не справляются с проверкой сайтов, у которых большое количество

страниц. ComparseR же сканирует сайты с несколькими миллионами страницами.

Key Collector

Если вы выбираете программу, которая поможет качественно составить

семантическое ядро, то остановиться советую именно на Key

Collector. Разработчики программы позиционируют продукт, как персональный

помощник по сбору семантики. Да, этот инструмент очень удобен, он значительно

упростит вам процесс по подбору ключевых запросов для сайта.

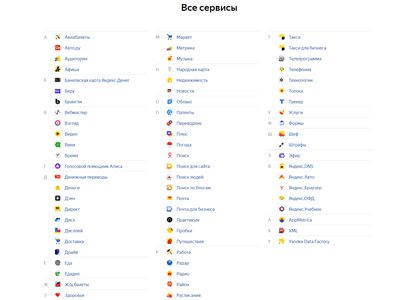

Программа не генерирует фразы, а собирает информацию с различных сервисов:

Яндекс.Вордстат, Google Adwords, Rambler Adstat, Яндекс.Директ, также

используется информация из разных счетчиков, анализируются поисковые подсказки

и не только. Все подключенные к Key Collector системы, помогут собрать

максимально обширное, подходящее по вашему направлению семантическое ядро.

Главный минус программного продукта – он не бесплатный, стоимость первой

лицензии – 1800 рублей, цены на последующие лицензии варьируются от 1100

до 1400 рублей. Но, как у большинства платных разработок, инструмент имеет свою

бесплатную версию. Такой демоверсией считается программа

Slovoeb, именно этот младший помощник создан для знакомства с Key Collector.

Конечно, возможностей у бесплатного инструмента гораздо меньше, но понять, как

работает программа и какие задачи решает, вы сможете.

Таблица сравнения возможностей Key Collector и Slovoeb:

| Функция |

Key Collector |

Slovoeb |

| Определение релевантных страниц |

|

|

| Сбор позиций фраз (без истории) |

|

|

| Сбор базовой частотности по Яндекс.Вордстату |

|

|

| Сбор уточняющей частотности по Яндекс.Вордстату |

|

|

| Сбор морфологической частотности по Яндекс.Вордстату |

|

|

| Пакетный сбор по Яндекс.Вордстату |

|

|

| Пакетный сбор по Google.Adwords |

|

|

| Определение сезонности запроса |

|

|

| Сбор подсказок поисковых систем |

|

|

| Сбор конкуренции в поисковой выдаче Яндекса, Google, Mail.Ru |

|

|

| Сбор количества вхождений запроса в Title |

|

|

| Сбор количества главных страниц в поисковой выдаче |

|

|

| Определение стоимости ключа по контекстной рекламе, по агрегатору |

|

|

| Прогноз трафика по контексту, по агрегаторам |

|

|

| Помощь в перелинковке страниц |

|

|

Эта сравнительная таблица дает нам понять, что возможностей у платной

программы гораздо больше, хотя в перечень я включила далеко не все функции.

Поэтому если вы поставили перед собой задачу максимально эффективно и правильно

собрать семантическое ядро, не поскупитесь и потратьте 1800 на платную версию.

А о том, как работать со SlovoEb, мы уже рассказывали в одной из статей.

RDS Bar

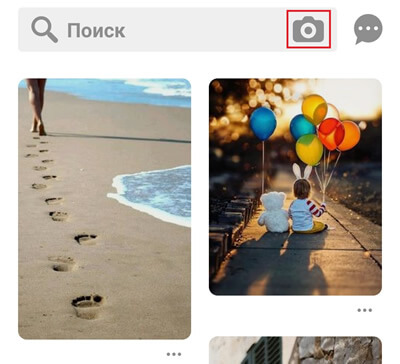

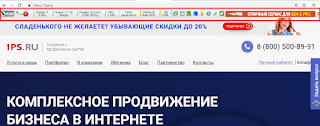

RDS Bar – бесплатное расширение для браузера, которое позволит проводить

быстрый анализ основных SEO-параметров сайта и страниц. Это дополнение

встраивается в Google Chrome, Mozilla Firefox и другие браузеры и отображается

в виде встроенной панели инструментов:

У RDS Bar два больших плюса: инструмент бесплатный, доступен каждому и его

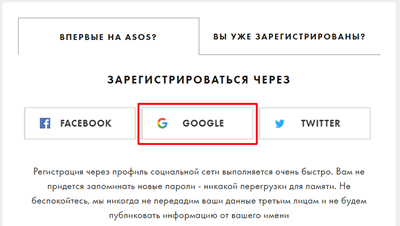

очень легко внедрить в свой браузер. Инструкция по установке включает всего три

шага:

-

Скачайте расширение для своего браузера.

- Зайдите в настройки браузера → Инструменты → Расширения → включите плагин.

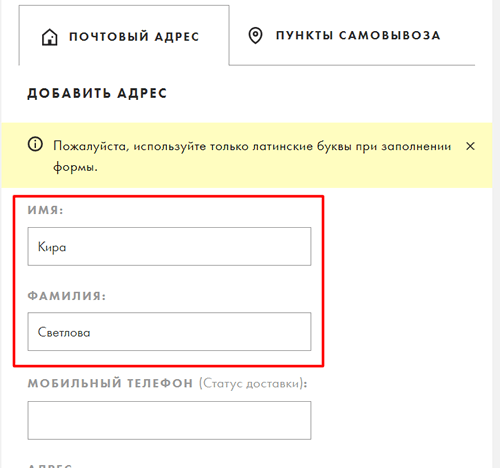

- Чтобы иметь доступ ко всем возможностям,

зарегистрируйтесь в RDS bar.

RDS Bar показывает:

-

Теги title, description и заголовки Н1 для страницы.

- Параметры Индекса качества сайта (ИКС).

- Количество проиндексированных страниц Яндексом и Google.

- Количество входящих и исходящих ссылок.

- Рейтинг посещаемости Alexa.

- Количество страниц, проиндексированных Rambler, Bing.com и Yahoo.

- Посещаемость на основе различных источников. Кстати, мы уже писали статью

о том, как можно анализировать посещаемость сайтов конкурентов с помощью RDS

bar.

- Наличие на сайта файла robots.txt и карты сайта (sitemap.xml).

- Информацию о покупных ссылках.

И это далеко неполный перечень возможностей RDS Bar. Инструмент очень полезен

для веб-мастеров и SEO-оптимизаторов, он позволит быстро узнать информацию

об основных параметрах сайта. Кроме того, плагин помогает анализировать сайты

конкурентов. Расширение бесплатно, поэтому советую уже сегодня установить его.

Megaindex

Megaindex (Мегаиндекс) – очень востребованный инструмент для анализа сайта,

аналитики и его продвижения. На одной площадке вы сможете найти несколько

десятков инструментов для проверки позиций сайта и его видимости в поисковиках,

для подбора ключевых фраз, поиска входящих и исходящих ссылок, аудита сайта

и не только. Если вы занимаетесь продвижением и оптимизацией сайтов, то этот

продукт, на мой взгляд, обязателен к использованию.

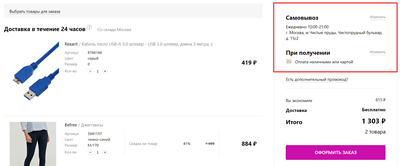

Мегаиндекс предлагает несколько

тарифных планов, каждый из которых отличается включенными в пакет функциями.

Есть и бесплатный, но возможности у этого тарифа крайне скудные. Итак, давайте

посмотрим, что же предлагает нам Мегаиндекс и нужно ли тратить бюджет на его

покупку.

-

Раздел «Анализ сайта» представит общую информацию о проекте: информацию

по переходам из органической выдачи и контекста, количество проиндексированных

страниц и внешних ссылок.

Видимость сайта из разных источников в процентом соотношении:

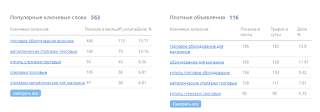

Ключевые фразы, по которым на сайт переходят из органической выдачи и платных

объявлений.

Информацию о конкурентах:

-

Инструмент «Внешние ссылки» – с его помощью вы сможете детально изучить

ссылочный профиль своего сайта: количество ведущих на сайт ссылок, типы ссылок

(анкорные или безанкорные), страницы, на которые ведут, а также сайты-доноры,

с которых идут ссылки. Также вы сможете проанализировать график

добавления/удаления ссылок и посмотреть каждую ссылку отдельно.

Когда мне нужно узнать, как обстоят дела на сайте со ссылками, то после

анализа Вебмастера, я сразу же иду на Мегаиндекс – здесь можно изучить все

тщательно, в деталях.

-

Инструмент «Видимость сайта». Этот раздел поможет увидеть ключевые запросы,

по которым люди находят ваш сайт из органики и рекламных объявлений,

дополнительно будут указаны релевантные страницы. Кроме того, здесь вы увидите

информацию по конкурентам, пересечение с ними по показу согласно запросам

пользователя.

-

Инструмент «Анализ сниппетов» – позволяет увидеть, как показываются сниппеты

сайта постранично в поисковых системах, какой запрос выделяет робот в сниппете.

-

«Подбор ключевых запросов и кластеризация ядра» – отличный инструмент для

сбора семантического ядра. Подборщики семантики от Мегаиндекса подойдет тем,

у кого сайт еще не создан. На основе сайтов конкурентов сервис соберет для вас

эффективные ключевые запросы с указанием количества показов и сайтов

конкурентов, продвигающимся по этим запросам. Помимо того что вы соберете

ключевые фразы, сможете дополнительно их разбить по группам.

alt="подбор ключевых запросов в Мегаиндексе"

Опять же это лишь малая часть возможностей, которые предлагает своим

пользователям онлайн-сервис Megaindex. Но даже этот небольшой список доказывает

полезность инструмента и его значимость для веб-мастеров и оптимизаторов.

Advego

Advego.com – еще один полезный инструмент, о котором вы наверняка уже

слышали и, скорее всего, даже применяли в работе. Сервис №1 для копирайтеров,

наряду с Главредом и Text.ru, рекомендуется использовать сервис Адвего. Именно

он помогает провести анализ: как оптимизирован ваш текст, не переспамлен ли

он ключевыми словами, не «переборщили» ли вы с количеством союзов, местоимений

и стоп-слов. Кроме проверки сайта на тошноту, здесь можно проверить тексты

на уникальность и наличие орфографических ошибок.

Итак, давайте на примерах посмотрим, как работает главный инструмент для

корирайтинга.

-

Адвего Антиплагиат – программа платная: доступны разные пакеты

от 270.00 рублей. Но можно скачать программу Advego Plagiatus – она проводит

проверку сайта на уникальность, предоставляя все источники, на которых находятся

совпадения. Минус программы – капча: иногда все работает без нее, но бывает, что

капчу приходится вводить каждые 30 секунд.

-

Проверка орфографии. Имеющиеся в тексте орфографические ошибки и опечатки

будут выделены красным цветом.

-

SEO-анализ текста – раздел, который позволяет провести семантический анализ

текста. Анализ контента включает количество символов в тексте, «водность»,

показатели академической и классической тошноты текста.

Семантическое ядро. В этом блоке будут указаны ключевые

слова, входящие в текст. Ваша задача, чтобы в ТОПе находились те запросы, под

которые вы оптимизируете свой текст.

Стоп-слова. Указаны предлоги, союзы, личные местоимения

и различные стоп-слова, количество которых лучше сокращать при написании

текстов.

Под занавес

Существует огромное количество программ, сервисов и других продуктов, которые

можно использовать, чтобы оптимизировать и продвигать свой сайт самостоятельно.

В этой статье мы рассказали вам о нескольких из них, которые мы не просто

рекомендуем, но и используем в работе сами. Советуем и вам. =)

А если у вас нет время на продвижение сайта, рекомендуем обратиться

к профессионалам и заказать

SEO-продвижение сайта.